Der vollstaendige Robots.txt Guide: Suchmaschinen-Crawler steuern

Erfahren Sie, wie Sie eine robots.txt-Datei schreiben und Suchmaschinen-Crawler effektiv verwalten.

Rolle und Grenzen von Robots.txt

Robots.txt ist eine Textdatei im Stammverzeichnis einer Website, die Suchmaschinen-Crawlern mitteilt, welche Seiten gecrawlt werden sollen. Sie ist Teil des 1994 eingefuehrten Robots Exclusion Protocol und wird seit den Anfaengen des Webs als Standard verwendet.

https://example.com/robots.txt

Aber ein wichtiger Punkt muss klargestellt werden: robots.txt ist eine Empfehlung. Gut entwickelte Suchmaschinen-Bots respektieren sie, aber boesartige Bots oder Web-Scraper koennen sie ignorieren. Daher sollte robots.txt nicht als Sicherheitswerkzeug verwendet werden. Sensible Daten muessen durch Authentifizierung und Zugangskontrolle geschuetzt werden.

Wie Crawler robots.txt verarbeiten

Wenn Suchmaschinen-Crawler eine Website besuchen, pruefen sie zuerst die robots.txt. Die Verarbeitungsreihenfolge ist wie folgt:

/robots.txtanfordern- Wenn Datei nicht existiert - Alle Seiten zum Crawlen erlaubt

- Wenn Datei existiert - Crawlen gemaess Regeln

- Passenden User-agent-Block finden

- Spezifischste Regel anwenden

Wichtig bei der Regelzuordnung: Wenn Allow und Disallow auf denselben Pfad angewendet werden, hat die spezifischere Regel Vorrang. Bei gleicher Spezifitaet hat Allow Vorrang.

Detaillierte Syntax-Anleitung

Grundlegende Direktiven

User-agent: *

Disallow: /admin/

Allow: /admin/public/

Sitemap: https://example.com/sitemap.xml

Crawl-delay: 10

| Direktive | Beschreibung | Beispiel |

|---|---|---|

| User-agent | Ziel-Crawler festlegen (* fuer alle Bots) | User-agent: Googlebot |

| Disallow | Crawling-Verbot fuer Pfad | Disallow: /private/ |

| Allow | Crawling erlauben (Ausnahme zu Disallow) | Allow: /private/open/ |

| Sitemap | Sitemap-URL (absoluter Pfad) | Sitemap: https://... |

| Crawl-delay | Crawling-Intervall (Sekunden) - nur von einigen Bots unterstuetzt | Crawl-delay: 10 |

Wildcards und Pfadende-Markierung

Robots.txt unterstuetzt eingeschraenktes Pattern-Matching:

*- Beliebige Zeichenkette (0 oder mehr)$- Ende des Pfads

# Alle .pdf-Dateien blockieren

Disallow: /*.pdf$

# URLs mit Query-Parametern blockieren

Disallow: /*?

# Bestimmte Parameter blockieren

Disallow: /*?sort=

Disallow: /*?filter=

# URLs mit Session-ID blockieren

Disallow: /*sessionid

# Alle PHP-Dateien in bestimmtem Verzeichnis blockieren

Disallow: /scripts/*.php$

Hinweis: Wildcards werden nur fuer Pfad-Matching verwendet. Regulaere Ausdruecke werden nicht unterstuetzt.

Wichtige Suchmaschinen- und KI-Crawler

Es ist nuetzlich, die wichtigsten Bots zu kennen, die Websites besuchen:

Suchmaschinen-Bots

| User-agent | Dienst | Beschreibung |

|---|---|---|

| Googlebot | Google Suche | Fuer Websuche |

| Googlebot-Image | Google Bilder | Fuer Bildersuche |

| Bingbot | Bing | Microsoft-Suche |

| Yeti | Naver | Koreanische Suche |

| Baiduspider | Baidu | Chinesische Suche |

| DuckDuckBot | DuckDuckGo | Datenschutz-Suchmaschine |

KI-Crawler (seit 2024 stark zunehmend)

| User-agent | Dienst | Beschreibung |

|---|---|---|

| GPTBot | OpenAI | ChatGPT-Trainingsdaten |

| ChatGPT-User | OpenAI | ChatGPT-Browsing-Funktion |

| CCBot | Common Crawl | Offene Datensatzsammlung |

| anthropic-ai | Anthropic | Claude-Trainingsdaten |

| Claude-Web | Anthropic | Claude-Websuche |

| Google-Extended | Gemini-Trainingsdaten |

Um KI-Trainings-Crawler zu blockieren:

# KI-Trainings-Crawler blockieren

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: Google-Extended

Disallow: /

Praxisbeispiele: Situationsabhaengige Konfiguration

Alles erlauben (Standard)

User-agent: *

Allow: /

Alles blockieren (Entwicklungs-/Staging-Umgebung)

User-agent: *

Disallow: /

Allgemeine Website

User-agent: *

Allow: /

# Admin-Bereich

Disallow: /admin/

Disallow: /wp-admin/

Disallow: /dashboard/

# Persoenlicher Benutzerbereich

Disallow: /account/

Disallow: /profile/

Disallow: /my-*/

# Suchergebnisse (Doppelte Inhalte vermeiden)

Disallow: /search/

Disallow: /*?q=

Disallow: /*?s=

# Temporaere/Entwicklungsdateien

Disallow: /tmp/

Disallow: /staging/

Disallow: /_*/

# Sitemap

Sitemap: https://example.com/sitemap.xml

E-Commerce-Website

User-agent: *

Allow: /

# Kaufprozess (Crawling nicht erforderlich)

Disallow: /cart/

Disallow: /checkout/

Disallow: /order/

# Benutzerkonto

Disallow: /my-account/

Disallow: /wishlist/

# Gefilterte/Sortierte Produktlisten (Doppelte vermeiden)

Disallow: /*?sort=

Disallow: /*?filter=

Disallow: /*?color=

Disallow: /*?size=

Disallow: /*&

# Interne Suche

Disallow: /search/

# Preisvergleichs-Bots erlauben (optional)

User-agent: PriceSpider

Allow: /

Sitemap: https://example.com/sitemap.xml

Sitemap: https://example.com/product-sitemap.xml

Blog/Medien-Website

User-agent: *

Allow: /

# Tag/Kategorieseiten (optional - bei Bedenken wegen doppelter Inhalte)

Disallow: /tag/

Disallow: /category/page/

# Autorenarchive

Disallow: /author/

# Anhangsseiten

Disallow: /attachment/

# Direkter Zugriff auf Mediendateien

Allow: /wp-content/uploads/

Sitemap: https://example.com/sitemap.xml

Sitemap: https://example.com/news-sitemap.xml

Haeufige Fehler und Loesungen

1. Fehlender Schraegstrich

# Falsch - Blockiert alle Pfade, die mit "admin" beginnen

Disallow: admin

# Richtig - Blockiert nur das /admin/-Verzeichnis

Disallow: /admin/

2. Gross-/Kleinschreibungsfehler

Direktiven-Namen unterscheiden Gross-/Kleinschreibung:

# Falsch

user-agent: *

disallow: /admin/

# Richtig

User-agent: *

Disallow: /admin/

3. Rendering-Probleme durch CSS/JS-Blockierung

Seit 2015 rendert Google Seiten, um Inhalte zu verstehen. Das Blockieren von CSS und JavaScript kann dazu fuehren, dass Google die Seite nicht richtig versteht:

# Falsch - Rendering-Ressourcen blockiert

Disallow: /css/

Disallow: /js/

Disallow: *.css$

Disallow: *.js$

# Richtig - Statische Ressourcen erlauben

Allow: /css/

Allow: /js/

Allow: /images/

4. Versehentliche Blockierung der gesamten Website

# Sehr gefaehrlich! Blockiert die gesamte Website

User-agent: *

Disallow: /

Wenn diese Einstellung in der Produktion deployed wird, kann die Website aus den Suchergebnissen verschwinden.

robots.txt vs. meta robots vs. X-Robots-Tag

Die drei Methoden haben unterschiedliche Zwecke und Prioritaeten:

| Methode | Ort | Zweck | Crawling | Indexierung |

|---|---|---|---|---|

| robots.txt | Stammverzeichnis | Crawling-Steuerung | O | X |

| meta robots | HTML head | Indexierungs-Steuerung | X | O |

| X-Robots-Tag | HTTP-Header | Nicht-HTML-Ressourcen | X | O |

Wichtig: Auch wenn mit robots.txt blockiert, kann eine Seite in den Suchergebnissen erscheinen. Wenn andere Websites darauf verlinken, kennt Google die URL und kann sie ohne Inhalt mit nur der URL anzeigen.

Um vollstaendig aus den Suchergebnissen zu entfernen:

<!-- Im head der betreffenden Seite hinzufuegen -->

<meta name="robots" content="noindex, nofollow">

Methoden zur robots.txt-Validierung

Google Search Console

- Search Console aufrufen

- Im linken Menue "Einstellungen" - "robots.txt"

- Mit "Live-Test"-Funktion URL-Blockierungsstatus pruefen

Ueber Kommandozeile pruefen

# Aktuellen robots.txt-Inhalt pruefen

curl https://example.com/robots.txt

# Aus Sicht eines bestimmten Bots simulieren (Python erforderlich)

pip install robotexclusionrulesparser

python -c "

import robotexclusionrulesparser as rerp

rp = rerp.RobotExclusionRulesParser()

rp.fetch('https://example.com/robots.txt')

print(rp.is_allowed('Googlebot', '/admin/'))

"

Crawl-Budget-Optimierung

Bei grossen Websites ist das "Crawl Budget" wichtig. Dies ist die Menge an Crawling-Ressourcen, die Google einer Website zuweist. Durch Blockieren unnoetiger Seiten mit robots.txt werden wichtige Seiten haeufiger gecrawlt.

Seiten, die Crawl-Budget verschwenden:

- Gefilterte/sortierte Produktlisten

- URLs mit Session-IDs

- Endlose Kalender

- Interne Suchergebnisse

- Druckversionen von Seiten

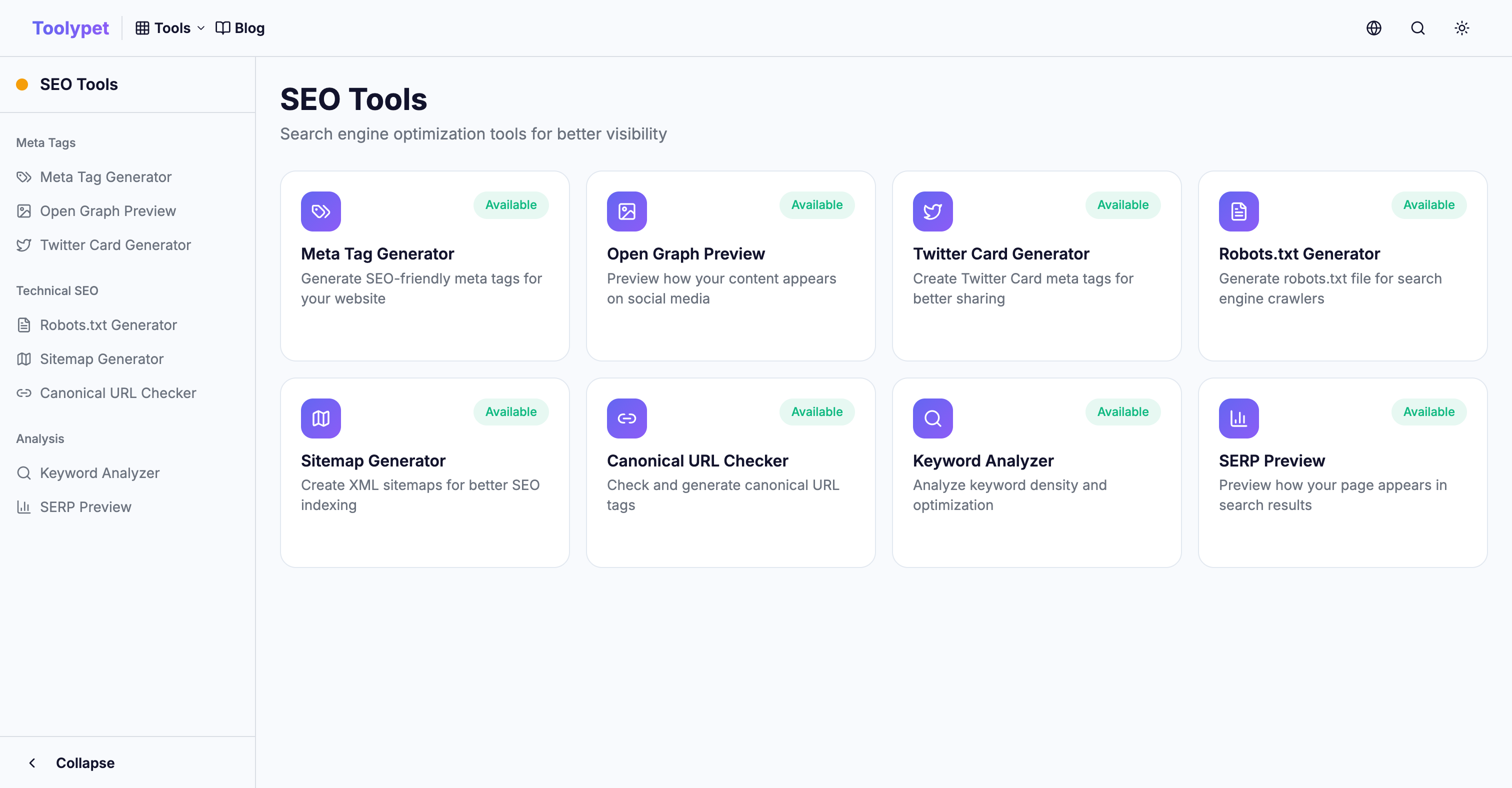

Toolypet Robots.txt Generator

Auch komplexe robots.txt einfach erstellen:

- Zu blockierende Pfadmuster auswaehlen

- Spezifische Bot-Blockierung einrichten

- Sitemap-URL eingeben

- Mit Vorschau pruefen

- Fertige Datei herunterladen

Mit einer korrekten robots.txt nutzen Sie Ihr Crawling-Budget effizient und sorgen dafuer, dass wichtige Inhalte in den Suchergebnissen gut erscheinen.