Robots.txt संपूर्ण गाइड: सर्च इंजन क्रॉलर नियंत्रित करना

robots.txt फाइल लिखने का तरीका और सर्च इंजन क्रॉलर को प्रभावी ढंग से प्रबंधित करने की विधि जानें।

Robots.txt की भूमिका और सीमाएं

robots.txt वेबसाइट की रूट डायरेक्टरी में स्थित टेक्स्ट फाइल है जो सर्च इंजन क्रॉलर को बताती है कि कौन से पेज क्रॉल करने हैं। 1994 में स्थापित Robots Exclusion Protocol का हिस्सा, वेब की शुरुआत से उपयोग होने वाला मानक है।

https://example.com/robots.txt

लेकिन एक महत्वपूर्ण बात स्पष्ट करनी होगी: robots.txt अनुशंसा है। अच्छे सर्च इंजन बॉट इसका सम्मान करते हैं, लेकिन दुर्भावनापूर्ण बॉट या वेब स्क्रेपर इसे अनदेखा कर सकते हैं। इसलिए robots.txt को सुरक्षा टूल के रूप में उपयोग न करें। संवेदनशील डेटा अनिवार्य रूप से ऑथेंटिकेशन और एक्सेस कंट्रोल से सुरक्षित करें।

क्रॉलर robots.txt कैसे प्रोसेस करता है

सर्च इंजन क्रॉलर वेबसाइट पर आने पर सबसे पहले robots.txt जांचता है। प्रोसेसिंग क्रम इस प्रकार है:

/robots.txtरिक्वेस्ट- फाइल न हो तो → सभी पेज क्रॉलिंग अनुमत

- फाइल हो तो → नियमों के अनुसार क्रॉलिंग

- अपने लिए लागू User-agent ब्लॉक खोजना

- सबसे विशिष्ट नियम लागू करना

नियम मैचिंग में महत्वपूर्ण बात, Allow और Disallow एक ही पाथ पर लागू हों तो अधिक विशिष्ट नियम प्राथमिक होता है। समान विशिष्टता पर Allow प्राथमिक।

व्याकरण विस्तृत गाइड

मूल निर्देश

User-agent: *

Disallow: /admin/

Allow: /admin/public/

Sitemap: https://example.com/sitemap.xml

Crawl-delay: 10

| निर्देश | विवरण | उदाहरण |

|---|---|---|

| User-agent | लक्षित क्रॉलर निर्दिष्ट (* सभी बॉट) | User-agent: Googlebot |

| Disallow | क्रॉलिंग प्रतिबंधित पाथ | Disallow: /private/ |

| Allow | क्रॉलिंग अनुमत पाथ (Disallow का अपवाद) | Allow: /private/open/ |

| Sitemap | साइटमैप URL (एब्सोल्यूट पाथ) | Sitemap: https://... |

| Crawl-delay | क्रॉलिंग इंटरवल (सेकंड) - कुछ बॉट ही सपोर्ट | Crawl-delay: 10 |

वाइल्डकार्ड और पाथ एंड मार्कर

robots.txt सीमित पैटर्न मैचिंग सपोर्ट करता है:

*- सभी स्ट्रिंग (0 या अधिक)$- पाथ का अंत

# सभी .pdf फाइल ब्लॉक

Disallow: /*.pdf$

# क्वेरी पैरामीटर वाले URL ब्लॉक

Disallow: /*?

# विशेष पैरामीटर ब्लॉक

Disallow: /*?sort=

Disallow: /*?filter=

# सेशन ID वाले URL ब्लॉक

Disallow: /*sessionid

# विशेष डायरेक्टरी की सभी PHP फाइल ब्लॉक

Disallow: /scripts/*.php$

सावधानी: वाइल्डकार्ड केवल पाथ मैचिंग में उपयोग होते हैं। रेगुलर एक्सप्रेशन सपोर्टेड नहीं।

प्रमुख सर्च इंजन और AI क्रॉलर

वेबसाइट पर आने वाले प्रमुख बॉट जानना उपयोगी है:

सर्च इंजन बॉट

| User-agent | सर्विस | विवरण |

|---|---|---|

| Googlebot | Google सर्च | वेब सर्च के लिए |

| Googlebot-Image | Google इमेज | इमेज सर्च के लिए |

| Bingbot | Bing | Microsoft सर्च |

| Yeti | Naver | नेवर सर्च |

| Baiduspider | Baidu | चीनी सर्च |

| DuckDuckBot | DuckDuckGo | प्राइवेसी सर्च |

AI क्रॉलर (2024 के बाद तेज वृद्धि)

| User-agent | सर्विस | विवरण |

|---|---|---|

| GPTBot | OpenAI | ChatGPT ट्रेनिंग डेटा |

| ChatGPT-User | OpenAI | ChatGPT ब्राउज़िंग फीचर |

| CCBot | Common Crawl | ओपन डेटासेट संग्रह |

| anthropic-ai | Anthropic | Claude ट्रेनिंग डेटा |

| Claude-Web | Anthropic | Claude वेब सर्च |

| Google-Extended | Gemini ट्रेनिंग डेटा |

AI ट्रेनिंग क्रॉलर ब्लॉक करने के लिए:

# AI ट्रेनिंग क्रॉलर ब्लॉक

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: Google-Extended

Disallow: /

व्यावहारिक उदाहरण: स्थिति अनुसार सेटिंग

पूर्ण अनुमति (डिफॉल्ट)

User-agent: *

Allow: /

पूर्ण ब्लॉक (डेवलपमेंट/स्टेजिंग वातावरण)

User-agent: *

Disallow: /

सामान्य वेबसाइट

User-agent: *

Allow: /

# एडमिन क्षेत्र

Disallow: /admin/

Disallow: /wp-admin/

Disallow: /dashboard/

# यूज़र व्यक्तिगत क्षेत्र

Disallow: /account/

Disallow: /profile/

Disallow: /my-*/

# सर्च रिजल्ट (डुप्लिकेट कंटेंट रोकथाम)

Disallow: /search/

Disallow: /*?q=

Disallow: /*?s=

# अस्थायी/डेवलपमेंट फाइल

Disallow: /tmp/

Disallow: /staging/

Disallow: /_*/

# साइटमैप

Sitemap: https://example.com/sitemap.xml

ई-कॉमर्स साइट

User-agent: *

Allow: /

# खरीद प्रक्रिया (क्रॉलिंग अनावश्यक)

Disallow: /cart/

Disallow: /checkout/

Disallow: /order/

# यूज़र अकाउंट

Disallow: /my-account/

Disallow: /wishlist/

# फिल्टर/सॉर्ट प्रोडक्ट लिस्ट (डुप्लिकेट रोकथाम)

Disallow: /*?sort=

Disallow: /*?filter=

Disallow: /*?color=

Disallow: /*?size=

Disallow: /*&

# इंटरनल सर्च

Disallow: /search/

# प्राइस कंपेरिज़न बॉट अनुमति (वैकल्पिक)

User-agent: PriceSpider

Allow: /

Sitemap: https://example.com/sitemap.xml

Sitemap: https://example.com/product-sitemap.xml

ब्लॉग/मीडिया साइट

User-agent: *

Allow: /

# टैग/कैटेगरी पेज (वैकल्पिक - डुप्लिकेट कंटेंट चिंता पर)

Disallow: /tag/

Disallow: /category/page/

# ऑथर आर्काइव

Disallow: /author/

# अटैचमेंट पेज

Disallow: /attachment/

# मीडिया फाइल डायरेक्ट एक्सेस

Allow: /wp-content/uploads/

Sitemap: https://example.com/sitemap.xml

Sitemap: https://example.com/news-sitemap.xml

आम गलतियां और समाधान

1. स्लैश मिसिंग

# गलत - "admin" से शुरू होने वाले सभी पाथ ब्लॉक

Disallow: admin

# सही - /admin/ डायरेक्टरी ही ब्लॉक

Disallow: /admin/

2. केस एरर

निर्देश नाम केस-सेंसिटिव हैं:

# गलत

user-agent: *

disallow: /admin/

# सही

User-agent: *

Disallow: /admin/

3. CSS/JS ब्लॉक से रेंडरिंग समस्या

2015 से Google पेज रेंडर करके कंटेंट समझता है। CSS और JavaScript ब्लॉक करने पर Google पेज ठीक से नहीं समझ सकता:

# गलत - रेंडरिंग रिसोर्स ब्लॉक

Disallow: /css/

Disallow: /js/

Disallow: *.css$

Disallow: *.js$

# सही - स्टैटिक रिसोर्स अनुमति

Allow: /css/

Allow: /js/

Allow: /images/

4. गलती से पूरी साइट ब्लॉक

# बहुत खतरनाक! पूरी साइट ब्लॉक

User-agent: *

Disallow: /

यह सेटिंग प्रोडक्शन में डिप्लॉय करने पर सर्च रिजल्ट से गायब हो सकते हैं।

robots.txt vs meta robots vs X-Robots-Tag

तीन विधियों के अलग-अलग उपयोग और प्राथमिकता हैं:

| विधि | स्थान | उपयोग | क्रॉलिंग | इंडेक्सिंग |

|---|---|---|---|---|

| robots.txt | रूट डायरेक्टरी | क्रॉलिंग नियंत्रण | O | X |

| meta robots | HTML head | इंडेक्सिंग नियंत्रण | X | O |

| X-Robots-Tag | HTTP हेडर | नॉन-HTML रिसोर्स | X | O |

महत्वपूर्ण: robots.txt से ब्लॉक करने पर भी पेज सर्च रिजल्ट में आ सकता है। अन्य साइट से लिंक होने पर Google URL जान जाता है और कंटेंट बिना केवल URL दिखा सकता है।

सर्च रिजल्ट से पूरी तरह हटाने के लिए:

<!-- उस पेज के head में जोड़ें -->

<meta name="robots" content="noindex, nofollow">

robots.txt वेरिफिकेशन विधि

Google Search Console

- Search Console एक्सेस करें

- बाएं मेन्यू में "सेटिंग्स" → "robots.txt"

- "लाइव टेस्ट" फीचर से URL ब्लॉक स्थिति जांचें

कमांड लाइन से जांच

# वर्तमान robots.txt कंटेंट जांचें

curl https://example.com/robots.txt

# विशेष बॉट दृष्टिकोण से सिम्युलेशन (Python आवश्यक)

pip install robotexclusionrulesparser

python -c "

import robotexclusionrulesparser as rerp

rp = rerp.RobotExclusionRulesParser()

rp.fetch('https://example.com/robots.txt')

print(rp.is_allowed('Googlebot', '/admin/'))

"

क्रॉल बजट ऑप्टिमाइजेशन

बड़ी साइट में "क्रॉल बजट" महत्वपूर्ण है। यह Google द्वारा साइट को आवंटित क्रॉलिंग संसाधनों की मात्रा है। robots.txt से अनावश्यक पेज ब्लॉक करने पर महत्वपूर्ण पेज अधिक बार क्रॉल होते हैं।

क्रॉल बजट बर्बाद करने वाले पेज:

- फिल्टर/सॉर्ट प्रोडक्ट लिस्ट

- सेशन ID वाले URL

- अनंत कैलेंडर

- इंटरनल सर्च रिजल्ट

- प्रिंट वर्जन पेज

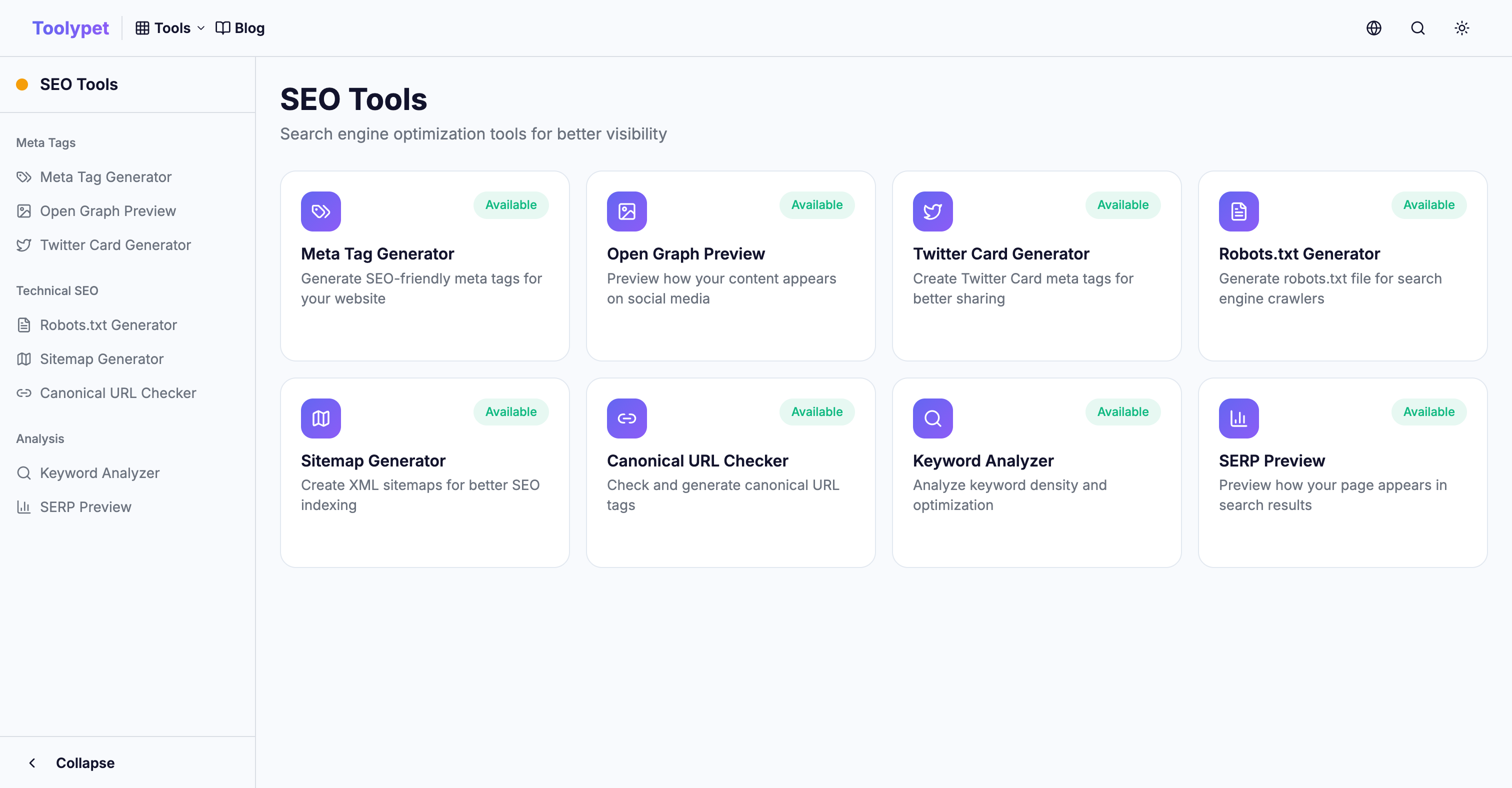

Toolypet Robots.txt Generator

जटिल robots.txt भी आसानी से बनाएं:

- ब्लॉक करने के पाथ पैटर्न चुनें

- विशेष बॉट ब्लॉक सेटिंग

- साइटमैप URL दर्ज करें

- प्रीव्यू से जांचें

- पूर्ण फाइल डाउनलोड करें

सही robots.txt से क्रॉलिंग बजट कुशलता से उपयोग करें और महत्वपूर्ण कंटेंट सर्च रिजल्ट में अच्छी तरह दिखे।